柯潔輸掉了與AlphaGo的第一戰。而在對戰前的深夜,柯潔在社交網絡上發布了一篇題為《最後的對決》的文章,充滿了易水訣別般的悲壯感,其中寫道:“現在的AI進步之快遠超我們的想象……我相信未來是屬于人工智能的。”引發王思聰在評論區質問:“喲,當時李(世石)和AlphaGo下的時候你那囂張勁兒去哪兒去了?”

2016年3月,在韓國棋手李世石以1:4不敵李世石後,這位少年得志的天才棋手確實曾在微博上撂下豪言“阿爾法狗勝得了李世石,勝不了我”,成為超級網紅。

雖然人類棋手在過去的一年里努力地研究AlphaGo的套路,試圖找到AlphaGo的弱點,但其實,AlphaGo也早已完成更新換代,今非昔比。柯潔在賽後發布會上表示,AlphaGo和去年判若兩“狗”,去年它的下法還很接近人類,現在感覺越來越接近“圍棋上帝”——圍棋中永不失誤的完美境界。

AlphaGo之父、DeepMind創始人戴密斯·哈薩比斯(Demis Hassabis)也在當天的賽後發布會上承認,之前與李世石交手的AlphaGo還是有一些漏洞的,他們在過去的一年里全力完善算法,彌補漏洞。

那麼,現在的AlphaGo到底發生了哪些改變?AlphaGo的研發公司DeepMind是如何升級它的?5月24日上午,在中國烏鎮人工智能高峰論壇上,哈薩比斯和AlphaGo團隊負責人Dave Silver(戴夫·席爾瓦)揭曉了新一代AlphaGo的奧秘。

深度強化學習:降低搜索樹的寬度和深度。本文圖片均來自 澎湃新聞記者 王心馨

這次柯潔面對的AlphaGo大師版,和去年李世石面對的AlphaGo李版主要有三大不同:首先,AlphaGo大師版擯棄人類棋譜,單純向AlphaGo李版的經驗學習;其次,AlphaGo大師版的計算量只有AlphaGo李版的十分之一,只需在單個TPU機器上運行;最後,AlphaGo大師版擁有更強大的策略網絡和價值網絡。

要理解AlphaGo的算法,首先要從1997年擊敗國際象棋神話卡斯帕羅夫的“深藍”算法說起。國際象棋的每一步都會引出下面三十種可能的走法,棋局的走向就和一棵不斷分出三十個分杈的大樹一樣。而“深藍”所做的,就是檢索完這棵大樹上的所有分杈,找出當下最優的那一步。“深藍”的計算能力因此能達到每秒1億個位置,是那個時代的突破性產物。

但到了圍棋這里,這種蠻力計算是不可行的。圍棋的每一步牽出的後續選擇有數百種。這麼龐大的搜索樹是無法被窮舉的。哈薩比斯說道,比起解構性的象棋,圍棋是個建構性的遊戲,也更依賴直覺,而非單純的計算。

而AlphaGo就依賴兩個網絡來簡化這棵龐大的搜索樹:降低搜索樹寬度的策略網絡和降低搜索樹深度的價值網絡。

席爾瓦介紹道,AlphaGo李版首先運用策略網絡進行深度學習,將大量人類棋譜輸入其中,根據人類經驗排除掉搜索樹上一部分的分杈。也就是說,雖然圍棋當前的每一步都有上百種可能性,但根據人類經驗,只有一部分是好的選擇,AlphaGo只需要搜索這些分杈,另一些根本就是“臭棋”。

然後,AlphaGo也不需要在這些分杈上一路搜索到底,模擬到棋盤結束才知道當前這步棋的優劣。在當前某個特定的選擇往下,AlphaGo只模擬幾步,就能得出一個分數。這個數值越大,AlphaGo獲勝的概率就越高。那麼,這個數值是怎麼得出的呢?這就要靠價值網絡進行強化學習。

在強化學習中,AlphaGo就根據策略網絡推薦的走法自我對弈,左右互搏,在經過反復自我訓練,積累了大量數據之後,AlphaGo就能更快地對當前走法的勝率有一個概念。

策略網絡和價值網絡配合形成的深度強化學習,雖然不能提高AlphaGo的計算能力(事實上,AlphaGo每秒計算1萬個位置,遠低于“深藍”),但卻能讓AlphaGo更“聰明”地計算。

AlphaGo自學成才:上一代是下一代的老師

而這次柯潔面對的AlphaGo大師版,比起去年李世石面對的AlphaGo李版,最大的不同是在深度學習環節,使用的大量訓練數據並非人類棋譜,而是AlphaGo李版自我對弈的數據。

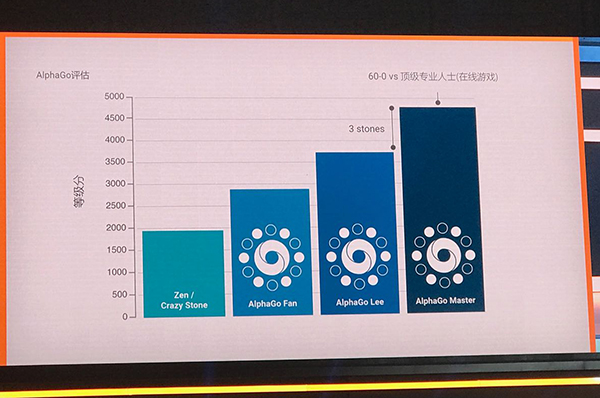

AlphaGo大師版對比AlphaGo李版三大升級。

席爾瓦說道:“AlphaGo大師版能如此高效運算的最主要原因是,我們使用了最好、最可用的數據來訓練它。我們所說的最好的數據不是來自于人,而是來自于AlphaGo自己。AlphaGo現在等于說是自學成才。我們讓它自己當自己的老師,而這一代的AlphaGo也會成為下一代AlphaGo的老師。”

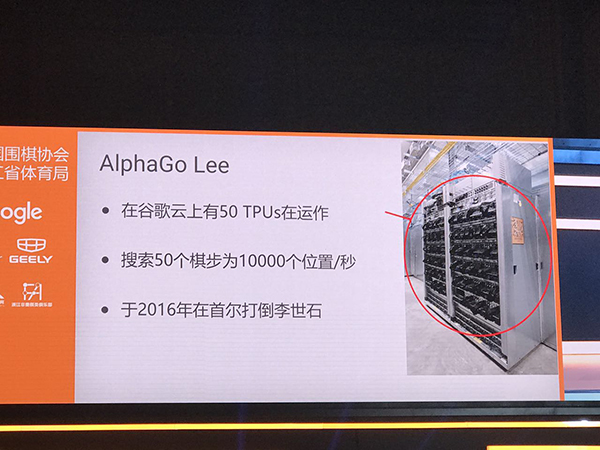

汲取了大量自我學習的經驗,這次與柯潔交手的AlphaGo大師版的策略網絡和價值網絡也因此更為強大。這大大提高了AlphaGo的運算效率 ,把計算量縮減到對戰李世石時的十分之一。從硬件來看,AlphaGo李版在下棋時還需要50個TPU(谷歌專為加速深層神經網絡運算能力而研發的芯片),AlphaGo大師版現在和柯潔對戰時只需要1個TPU。

而更強大的AlphaGo大師版又會帶來更優秀的數據,以訓練下一代AlphaGo。這是一個良性循環。

AlphaGo的迭代增強。

哈薩比斯說道,AlphaGo的首要目標還是要“追求完美”。在過去的數千年,人類都沒有達到圍棋的真理境界。他希望,AlphaGo能和人類共同努力,趨近圍棋真理。

[責任編輯:郭曉康]